安装配置

https://github.com/ostris/ai-toolkit

Win下,

git clone https://github.com/ostris/ai-toolkit.git

cd ai-toolkit

python -m venv venv

.\venv\Scripts\activate

pip install --no-cache-dir torch==2.7.0 torchvision==0.22.0 torchaudio==2.7.0 --index-url https://download.pytorch.org/whl/cu126

pip install -r requirements.txt

然后进入UI目录去启动

cd ui

npm run build_and_start

手动下载模型

不手动下载,第一次训练会卡很久很久

下到 G:\ai-toolkit\ai-toolkit\models-down\Lightricks\LTX-2

download_model.py:

import os

import sys

from pathlib import Path

# 使用 HF 镜像

os.environ["HF_ENDPOINT"] = "https://hf-mirror.com"

try:

from huggingface_hub import snapshot_download

except ImportError:

print("[错误] 未安装 huggingface_hub")

print("请运行: pip install huggingface_hub")

sys.exit(1)

# 目标目录

target_dir = Path("models-down/Lightricks/LTX-2")

target_dir.mkdir(parents=True, exist_ok=True)

repo_id = "Lightricks/LTX-2"

print(f"[信息] 下载模型: {repo_id}")

print(f"[信息] 目标目录: {target_dir.absolute()}")

print("[信息] 模式: 音频 + 视频 LoRA 训练(裁剪下载)")

print()

try:

snapshot_download(

repo_id=repo_id,

local_dir=str(target_dir),

local_dir_use_symlinks=False,

resume_download=True,

# ✅ 只允许下载这些

allow_patterns=[

# 主模型

"ltx-2-19b-dev.safetensors",

# 视频相关

"transformer/**",

"vae/**",

# 音频相关

"audio_vae/**",

"vocoder/**",

# 文本条件

"text_encoder/**",

"tokenizer/**",

# 跨模态对齐(非常重要)

"connectors/**",

# diffusers 索引

"model_index.json",

],

)

print()

print("[成功] 必要模型文件下载完成")

print("[成功] 这是音频 + 视频 LoRA 训练的最小完整集合")

sys.exit(0)

except Exception as e:

print()

print(f"[错误] 下载失败: {e}")

sys.exit(1)

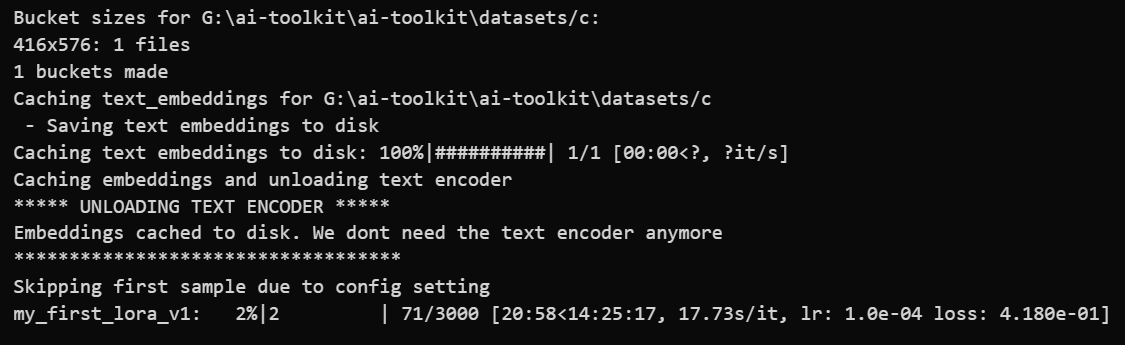

Lora训练预处理工作流

把视频去掉文字

ltx2 lora 视频训练lora

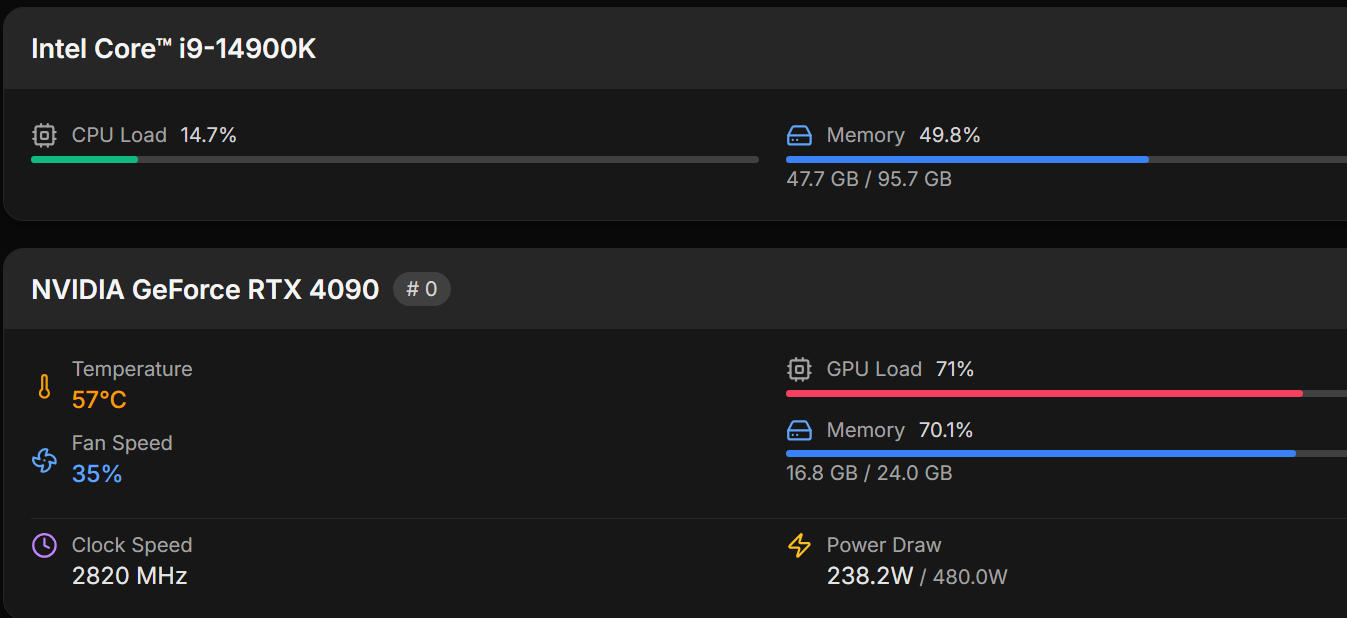

参数:Transformer float8

Text Encoder 4bit

Max Step Saves to Keep 4 改为10 多点选择

Caching text embeddings (省时)

只生512

底模是知名的模型,就不需要开baseline samples来浪费时间了

skip first sample (first sample耗时)

disable sampling 省时间,减少出错

强制stop训练

结束任务,删除.next和node_modules,运行npm run build_and_start